3. Homo Computatrum — Entre Ábacos e Wektabytes (História do Computador)

- Miguel João Ferreira

- 20 de nov. de 2017

- 9 min de leitura

Um Homem e uma Máquina Entram num Bar… Como se tornaram amigos?

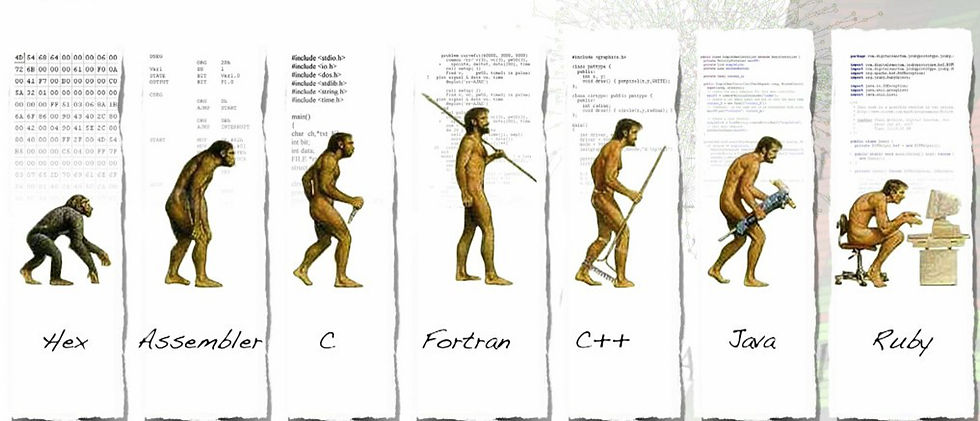

A relação do Homem com o computador adquiriu tal importância que esta máquina fascinante e complexa já é parte do nosso dia-a-dia. Na longa escala evolutiva do primata ao Homo-Sapiens-Sapiens (a acreditar nas teorias de Darwin e nas explicações da Ciência), podemos talvez dizer, sem estarmos muito errados, que chegámos a um nível de Evolução (ou devolução segundo os Velhos do Restelo) a que poderemos chamar Homo-Computatrum. Esta denominação põe em evidência a dependência que criámos face aos computadores.

Etimologicamente, “computador” vem da palavra latina computare, que quer dizer “calcular”. Representa portanto a capacidade (da pessoa ou, nestes dias, da máquina) de fazer cálculos. Neste capítulo, abordamos, de forma breve, a história do computador: como surgiu e como evoluiu até ao ponto em que o conhecemos hoje. Isto é certo: não começou com um CPU e um ecrã:

No séc. V a.C., encontramos já uma forma de calculadora analógica: o ábaco recebe as honras de primeiro computador — isto é, é o primeiro instrumento conhecido de cálculo, e terá sido fabricado na China. Este instrumento, constituído por um conjunto de varetas paralelamente alinhadas, era utilizado para fazer operações matemáticas de adição e subtração, com recurso a pequenas esferas inseridas ao longo dessas varetas. Com o passar do tempo, foi introduzido em outras culturas, na Babilónia, no Egito, na Grécia, em Roma, no Japão, etc., tendo passado assim por uma série de evoluções e inovações ou, simplesmente, por novos baptismos: suan-pan em chinês, face ao nipónico soroban.

Na Pérsia, pelo séc. IX, aparece Al-Khwārizmī, grande matemático (precursor da Álgebra) que, pelas suas descobertas (e pelo seu nome), dá origem aos nossos termos tão familiares algarismo e algoritmo.

Tivemos de esperar até ao séc. XVII para assistir a um novo progresso de monta: o inglês William Oughtred desenvolve a régua de cálculo; o escocês John Napier, os ossos de Napier (ou tabela de logaritmos); e o francês Blaise Pascal cria a primeira máquina de computar (Máquina de Pascal), em 1642. Composta por rodas interligadas que giravam durante o cálculo, pretendia realizar as quatro operações matemáticas, mas, na prática, conseguia apenas somar e subtrair, fazendo-se a multiplicação e a divisão por meio de operações indiretas (com recurso a repetições de soma e subtração). A ideia de Pascal foi completada alguns anos depois pelo filósofo e matemático alemão Gottfried Leibniz, abrindo assim caminho à máquina de calcular.

Devemos saltar mais dois séculos, até ao séc. XIX, para encontrar a máquina mecânica programável de Joseph-Marie Jacquard (que idealizou a programação funcional). Cansado do trabalho repetitivo no tear a que era constrangido, construiu uma máquina capaz de controlar a confecção de tecidos, através de cartões perfurados. Também neste século, Charles Babbage, o pai do computador programável, apresentou a máquina diferencial que consistia em efectuar de forma mais fácil cálculos de funções, da trigonometria ao logaritmo. Em 1837, Babbage criou a máquina analítica (também conhecida por engenho analítico), que aperfeiçoava a máquina diferencial. Porém, por questões técnicas, legais, financeiras e políticas, nunca chegou a ser construída. Em 1847, George Boole, o pai da lógica moderna, desenvolve o código binário (0s e 1s) em que 0 indicava “falso”, “inactivo” ou “desligado” e 1 indicava “verdadeiro”, “activo” ou “ligado”, com os valores intermédios como “mais ou menos activo” a serem indicados por meio de 2 ou mais algarismos. A lógica booleana é, hoje em dia, uma das bases da programação. Em 1880, Herman Hollerith responde às necessidades dos Censos nos EUA e desenvolve uma máquina capaz de acelerar o processamento de dados. Chamou-se-lhe máquina tabuladora. Em vez de escrever a informação num papel, os cidadãos deveriam apenas, nos campos que lhes correspondiam, perfurar a opção correta num cartão que depois seria lido pela tabuladora a uma velocidade muito superior à humana. Embalado por esse êxito, Hollerith criou a sua própria empresa chamada Tabulation Machine Company. Talvez este nome desconhecido nos diga mais qualquer coisa se soubermos que, anos depois, por associação com outros empresários, deu origem à International Business Machines, também conhecida por… IBM.

E eis-nos no séc. XX. Na 1ª metade deste século, assistiu-se ao desenvolvimento do computador mecânico que, gradualmente, foi integrando componentes electrónicos. Em 1930, Vannevar Bush fabricou, com base na lógica booleana, uma máquina de grandes dimensões, com motores eléctricos e válvulas termiónicas (tubo de vácuo), capaz de resolver qualquer problema, até equações diferenciais. Chamou-lhe analisador diferencial. Seguiu-se o Z1, desenvolvido pelo alemão Konrad Zuse, o 1º computador electro-mecânico, constituído por relés, capaz de fazer cálculos e de ler dados em fitas perfuradas. Estamos em 1936. Sucederam-lhe outras versões (Z2 a Z4) e, durante a 2ª Guerra Mundial, o desenvolvimento dos computadores recebeu novo impulso, graças à necessidade de calcular trajectórias e rotas e, principalmente, de desencriptar mensagens secretas inimigas. Neste campo, foi fundamental a contribuição de Alan Turing, dito o “pai das ciências computacionais”. Com base no seu modelo de computador universal, Turing desenvolveu uma máquina, hoje modelo dos computadores digitais, que se mostrou capaz de quebrar os códigos nazis e assim contribuiu enormemente para a antecipação do fim da 2ª Guerra Mundial. Passa um ano. Howard Aiken e Grace Hopper (analista de sistemas da Marinha dos Estados Unidos e grande programadora) desenvolvem na Universidade de Harvard, com base no cálculo analítico do Babbage, o Harvard Mark I. Funcionamento base: fita de papel perfurada com instruções codificadas. Grande evolução na programação, o Mark I conseguia calcular automaticamente sequências de operações aritméticas (até 23 dígitos).

1946: John Mauchly e John Eckert fabricam o Electronic Numerical Integrator and Computer (primeiro computador digital electrónico), vulgo ENIAC. Processava 5000 somas, 357 multiplicações e 38 divisões por segundo. Hoje é menos do que uma calculadora simples de bolso; na época era algo de revolucionário. Constituído por válvulas (tubos de vácuo), marca o início da 1ª Geração de computadores, que se estende até c. 1954. A 1ª Geração inclui momentos importantes como 1948: Freddie Williams e Tom Kilburn, Universidade de Manchester, dão origem à Manchester Automatic Digital Machine, MADM ou Manchester Mark I. Funciona com base em Autocode, uma das primeiras versões de linguagem de programação de alto nível. 1951: Jay Forrester e Kenneth Olsen criam no MIT o Whirlwind, o primeiro computador a processar informações em tempo real. Mauchly e Eckert criam nos EUA o UNIversal Automatic Computer (UNIVAC), primeiro computador eletrónico comercial. Funcionava através de processamento de lotes de cartões perfurados; seguido do Electronic Discrete Variable Automatic Computer (EDVAC), que o melhorou. Em Abril de 1952, a IBM lança o primeiro computador científico comercial, o IBM 701 ou Calculadora de Defesa.

1955: O transístor, inventado por Bardeen, Schockley e Brattain em 1947, depois do sucesso com a rádio e a TV, é finalmente integrado num computador. Muito menor do que as válvulas a vácuo; não exigia pré-aquecimento, consumia menos energia, gerava menos calor e era mais rápido e fiável. Os IBM 1620 e 1401 foram bons exemplos da sua aplicação. É o início da 2ª Geração de computadores que vai até 1964. Em 1954, a IBM lança o 704 (UCAE, Unidade de Controlo Analítico Electrónico), o primeiro computador comercial capaz de fazer cálculos com a vírgula flutuante (i.e., representação digital de números racionais). Corre com base na linguagem de alto nível FORTRAN. Seguiu-se-lhe o IBM 305 RAMAC (Random Access Method of Accounting and Control), primeiro computador a usar uma unidade de disco magnético com uma cabeça móvel de leitura. Em 1957 a IBM, líder nesta época, lançou o 610 Auto-Point Computer, concebido para ser usado por uma pessoa num escritório, com recurso a teclado e máquina de escrever automática com velocidade de 18 caracteres por segundo. 1962: Atlas Supervisor desenvolvido pela CDC (Control Data Corporation), supercomputador que executava muitos programas simultaneamente através do Clever Scheduling e uma linguagem de programação de alto nível. O seu sucessor, o CDC 6600, incluía já elementos que nos são familiares, como funções computacionais geridas por uma unidade de controlo (ALU — Arithmetical and Logical Unit), RAM (Random Access Memory) e memórias periféricas, processadores periféricos com memória interna para atender a pedidos de entrada e saída de dados e multiprogramação.

3ª Geração de Computadores: 1964. É marcada pela inclusão de circuitos integrados feitos de silício. Fabricou-se então o primeiro mini-computador (comercial), o PDP-8, da DEC (Digital Equipment Corporation). 1966: a IBM concebe um sistema operativo através de uma linha de comandos a que chamou Disk Operating System. Hoje conhecêmo-lo por DOS e associamo-lo à Microsoft que o desenvolveu em 1980 para a própria IBM. 1969: Armstrong chega à Lua; e, à Terra, chega o Multics (Multiplexed Information and Computing Service) prova da multiprogramação de um computador com multi-utilizadores. Apareceu também, num projeto do Departamento de Defesa dos EUA, a ARPANET. O que resultou desta rede, anos depois, foi… a Internet.

Começam os anos 70: A Intel revoluciona o mercado com o microprocessador. A IBM desenvolve o 370, com capacidade para um processador dual, suporte total para memória virtual e aritmética de 128 bits em vírgula flutuante. Nasce o Unix, que dará origem ao Linux e ao MacOS. O CPU integra-se definitivamente na arquitectura da máquina e dá início à 4ª Geração de computadores. Desse ano em diante, começam a desenvolver-se de forma continuada o MS-DOS (adaptado por Bill Gates e Paul Allen, olá Microsoft!) e desenvolvem-se as linguagens de programação orientadas a objeto como C++ e Smalltalk. Surgem os discos rígidos utilizados como memória secundária, as impressoras matriciais, os teclados com o layout actual; e a MITS (Micro Instrumentation and Telemetry Systems) cria o Altair 8880. É o princípio dos anos 80 e do boom do PC (personal computer), que começará, devagarinho, daí em diante, a entrar em todas as casas; e o fim da aplicação da melhor máquina do mundo para uso lúdico exclusivo dos Srs. Generais. Uns atrás dos outros, chegaram os Spectrum, os Amiga, os Commodore, os Macintosh, encostando mais e mais as máquinas de escrever a um canto, agilizando o trabalho em casa e criando um novo vício que desde então não parou de subjugar as novas gerações: os jogos de computador. Chegam as placas gráficas CGA (Color Graphics Adapter), EGA (Extended Graphics Adapter), VGA (Video Graphics Array) e SVGA (Super VGA) para uma cada vez melhor imagem e definição, com cada vez mais cores.

Num ápice, encontramo-nos nos anos 90 do séc. XX e, com eles, com a 5ª Geração de computadores. A sua principal característica é o desenvolvimento de processadores com milhões de transistores, os ULSI (Ultra Large Scale Integrated). Aparecem as arquiteturas de 64 bits, os discos rígidos com capacidade superior a 600 GB, as pen-drives com mais de 1 GB de memória e a utilização de disco óptico com mais de 50 GB de armazenamento. Linus Torvalds cria o Linux; a Microsoft o Windows 95; e os Sistemas Operativos com GUI (Graphic User Interface) ganham expressão e dão expressão redobrada à experiência informática do utilizador. Democratiza-se a informação com a rede que agora é de todos, a Internet, e, depois dela, com a World Wide Web que, de forma quase imediata, passou a ligar cada um de nós ao resto do mundo; primeiro com a lenta espera da linha telefónica, agora com a fibra que nos faz downloads de vários Giga em segundos.

“Em menos de um ai”, chegamos ao século XXI, com ecrãs plasma, LEDs, portáteis cada vez mais eficientes, potentes, rápidos, leves, pequenos e cada vez melhores definições; telefones inteligentes e tablets tão ou mais potentes do que muitos computadores multiplicam-se como cogumelos; inúmeros elementos das coisas de todos os dias são informatizados como prática comum; a trivialidade e o quotidiano ganham interactividade, normalmente para nosso conforto, outras vezes para nosso controlo. É o mundo da conectividade, das redes sociais, da tirania do sempre ligado, da tendência crescente para a sincronização, da ubiquidade, do permanentemente contactável. A expressão latina Quo Vadis? («Para onde vais?») cruza-se com o mote do filme de culto Sei o Que Fizeste no Verão Passado para resultar num estranho e às vezes assustador Sei Para Onde Vais, desde o Verão Passado. A Ficção Científica tem de se superar para continuar a ser ficção, as ficções de ontem são cada vez mais as realidades de hoje. O cinema fala-nos de máquinas inteligentes, e as Web Summits de que Lisboa se enche falam-nos de Inteligência Artificial, o novo Graal das Ciências Computacionais, cada vez mais possível e, apesar dos receios (de que mais adiante falaremos com mais pormenor), cada vez mais próxima. Os relógios estão computadorizados, os carros falam connosco e hão-de guiar-se sozinhos, as lâmpadas acendem-se e apagam-se ao bater das palmas, os quadros mudam de cor e de paisagem com um click de um controlo remoto consoante a nossa disposição, os frigoríficos estão ligados ao telemóvel para lhes vermos as entranhas e nos lembrarmos do que nos falta quando vamos às compras. Este é o nosso mundo, impossível e impensável há 50 anos atrás, absurdo há um século, demoníaco há pouco mais do que dois. As experiências continuam na procura do computador com emoções, e na senda da 6ª Geração de computadores, que ainda não chegou, que ainda está para vir, mas que já bate à porta: a dos supercondutores, com uma performance 30 vezes superior à dos melhores aparelhos de hoje.

De máquinas rudimentares e analógicas, vêmo-nos cobertos por um mundo digital de que estamos cada vez mais dependentes, que condiciona, por mais que queiramos ver-nos como o/a controlador/a, a maioria das nossas ações. De sistemas computacionais elementares, deparamo-nos com super-computadores capazes de operações que fazem inveja aos nossos maiores génios — quem não quereria poder processar os elementos racionais e objetivos da realidade com a precisão e a velocidade de um computador? — De ábacos rudimentares de madeira e pequenas esferas, chegamos à quantidade astronómica de armazenamento e cálculo dos Petabytes (do mais moderno supercomputador dos nossos dias, em Hong Kong que processa até 1 quadrilhão de cálculos por segundo). E o desenvolvimento não pára. Um dia, não tão longínquo, falaremos de Wectabytes (2 Bytes à potência de 100) como quem fala em ir comprar maçãs — quem sabe não é o próximo Apple?

Em 15 parágrafos, viajámos à origem da maçã. Vamos agora ver como é feita por dentro. De súbito, impõem-se-nos duas questões: Se o computador foi feito à imagem do Homem, de que é feita esta incrível criação? E de que é feito o seu deus? O próximo capítulo, portanto, é feito de anatomias. Talvez pudesse ser esta a máxima de um sábio: «Conhecendo o corpo, aprende-se o espírito». É o que iremos procurar fazer.

(Investigação: Miguel João Ferreira e David Melo

Texto: Miguel João Ferreira, com base em notas de David Melo)

Comentários